打造软件版AI加速器,CoCoPIE将普惠AI做成了生意

你知道实现L4级别自动驾驶所需的硬件成本是多少吗?

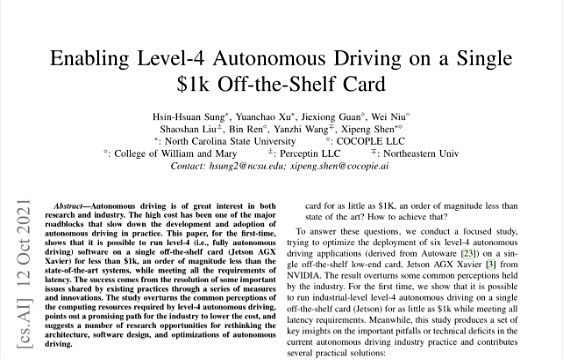

主流观点认为,运行L4级别自动驾驶软件,需要依赖大量的计算资源,这需要很大的硬件设备成本。其中,仅一个能够满足L4级别自动驾驶需求的AI控制平台便要花费上万美金。然而,CoCoPIE并不赞同这些“主流观点”,并用其最新研究告诉我们截然不同的答案——业界可以在1000美金级别的主流单片设备上,实现L4级别的自动驾驶。

这家人工智能技术公司证实了,在满足所有延迟要求的同时,只需单个低于1000美元的现成设备(NVIDIA Jetson AGX Xavier) ,即可运行6个工业级L4级自动驾驶应用程序。这是什么概念?要知道一个自动驾驶汽车(L2级别)的实验模型尚且需要30万美元的成本,搭载执行自动驾驶软件的硬件是其中最昂贵的组件。

优化算法模型

另辟蹊径助推自动驾驶普及

“L4级别的自动驾驶对软件性能要求较高,需要大量的深度神经网络来对道路情况进行捕捉、识别、计算,并做出适时地反应,如此海量的数据和高性能的计算要求,很难让L4级别的自动驾驶软件运行在低端的硬件上。”CoCoPIE公司CTO慎熙鹏在采访中表示。而相对高端的搭载自动驾驶软件的硬件系统往往动辄上万美元,代价相对高昂。

为此,以在IoT以及移动端普及实时人工智能为使命的CoCoPIE开始新的思考:全自动驾驶真的需要那么多计算资源吗?目前低端设备在全自动驾驶应用中性能不足的原因是什么?L4级自动驾驶是否有可能在一张现成的卡上以低至1000美元的价格实现实时性能?这一次,CoCoPIE将“在不额外增加人工智能专用硬件的情况下让现有处理器实时地处理人工智能应用”的思路用在了自动驾驶领域。

于是CoCoPIE在单个现成的AI芯片产品上对L4级别的自动驾驶软件进行深入优化,并取得初步成功。“之所以CoCoPIE能够让L4级别的自动驾驶在更低端的设备上运行,是因为CoCoPIE对AI算法模型进行了全栈的、协同的优化,从模型本身优化到代码,再到运行时的资源调度,CoCoPIE充分考虑了各个部分之间的关系、影响。”

采访中,慎熙鹏还重点分享了主流自动驾驶技术的缺陷,及CoCoPIE提出的解决方案。慎熙鹏表示:“当预先调度方案调度单个低端设备上的自动驾驶程序时,计算资源严重不足,这时,CoCoPIE提出即时优先级调整的方案,通过即时调整任务的关联和优先级来解决。”

另外,针对“由于硬件模型设计和实现的某些原因,某些加速器未被完全利用”的情况,CoCoPIE采用一种硬件感知模型定制(hardware-aware model customization)的方法,通过弥合DNN模型与多种类型的加速器之间的差距,显着提高了加速器的利用率。而面对“自动驾驶调度算法无法处理可以使用多种类型加速器的混合工作负载”的问题,“我们提出了基于 DAG 实例化的调度(instantiation based scheduling),一种通过基于加速器的 DAG 实例化扩展自动驾驶调度以满足需求的方法。”慎熙鹏表示。

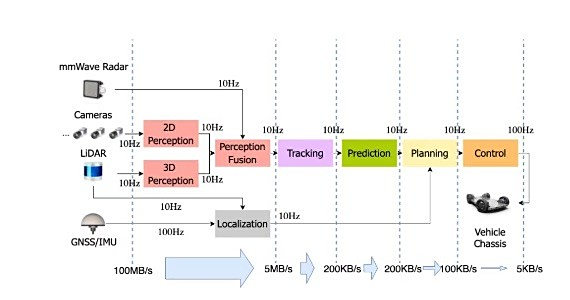

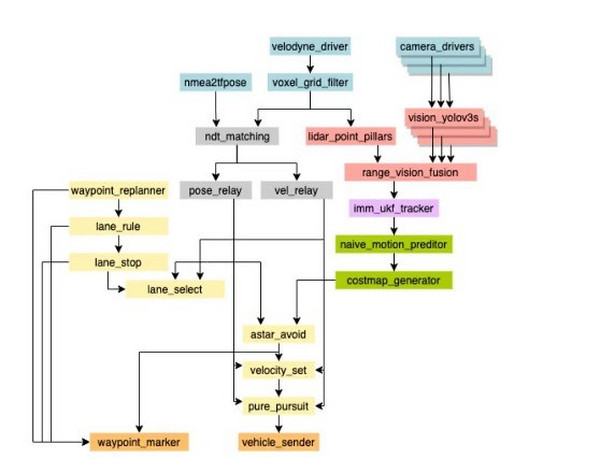

【来自 Autoware 自动驾驶应用程序(ADApp)中的详细任务。感测(蓝色),感知(红色),定位(灰色),跟踪(紫色),预测(绿色),规划(黄色)和最终控制输出(橙色)。】

事实上,该研究颠覆了业界对L4级别自动驾驶所需计算资源的普遍认识,为行业降低成本指出了一条可行道路,并提出了一些重新思考自动驾驶的软件架构、设计和优化的研究机会,对解决当下汽车行业芯片荒问题亦有帮助。慎熙鹏提及:“目前,我们正在与一家自动驾驶公司PerceptIn进行深入合作。”比特网了解到,PerceptIn主要研发以视觉为主的低速无人驾驶技术方案,产品包括”DragonFly+”无人驾驶FPGA计算平台、”DragonFly Pod”无人驾驶园区车”DragonFly Bus”无人驾驶观光车等。

软件版加速器

CoCoPIE以普及实时人工智能为使命

在1000美金级别的主流设备上实现L4级别的自动驾驶,这是CoCoPIE“通过协同优化人工智能模型的压缩-编译过程,在主流终端设备上实现实时的人工智能”这一技术在自动驾驶领域的缩影。CoCoPIE认为,目前终端设备上的主流硬件,在运算人工智能模型时,尚有很大潜力未被开发。

为此,CoCoPIE设计了一种人工智能模型的压缩-编译协同方案,通过将压缩和编译两个步骤进行协同设计,有效利用现有主流芯片的算力,使其能够实时运行人工智能模型,不需要特殊的人工智能硬件加速器。

基于这种压缩-编译协同方案,CoCoPIE搭建了CoCo-Gen和CoCo-Tune等产品。其中,CoCo-Gen通过将基于模式的DNN剪枝与基于模式的感知生成代码相协同,生成高效的 DNN 执行代码,而CoCo-Tune则能够显著缩短确定要修剪的适当DNN参数集的过程。慎熙鹏表示:“CoCo-Gen的剪枝办法,可以将AI模型缩小,还能确保剪完以后的模型有规则,能够利用硬件的效能。”

而CoCo-Tune能够做超参的快速调优,慎熙鹏分享到:“在人工智能的模型和人工智能的代码生成的过程中会产生一些超参,这些超参会影响代码模型的质量,CoCo-Tune能够让这些超参能够很地被调出来,而调试出来的模型也能非常好。”

不仅如此,慎熙鹏进一步分享到:“CoCoPIE优化了常用的AI模型任务集,包括正在开发的云服务,该云服务可以让更多的用户直接简单地能够使用CoCo-Gen和CoCo-Tune等优化工具链。”

携手合作伙伴

CoCoPIE持续建设普惠AI生态

慎熙鹏表示:“CoCoPIE成立至今,已有一年多的时间,这期间CoCoPIE不仅迎来了团队的壮大,更是在2021年8月份获得数千万元的A轮融资,并一直致力于Making Ubiquitous AI Sweet As PIE,让无处不在的人工智能够像简单的工具一样让大家使用。”

发展至今,CoCoPIE已经逐渐深入IoT、数字媒体、半导体等领域,持续赋能行业发展,其中在包括家居、车载、制造、医疗、司法等行业中,CoCoPIE的技术共计将影响9550亿美金的IoT市场。而在数字媒体领域,CoCoPIE的技术将直接影响869亿美金的数字媒体市场,实时的本地AI将为数字媒体行业带来一场变革。

在半导体领域,据测算,到2025年AI芯片市场将达到454亿美金规模,若将CoCoPIE为市场带来的加持作用加入考量,则总市场规模将达1100亿美金,CoCoPIE将持续为芯片厂商赋能。

以与腾讯、Cognizant合作为例,在与腾讯合作的过程中,CoCoPIE的技术帮助其部分视频业务进行实时本地化的超分辨率运算。Cognizant是一家全球顶级的软件外包服务商,CoCoPIE正在帮助其大量客户实现人工智能的本地化运行。

慎熙鹏表示:“目前,腾讯、滴滴、Cognizant等公司已经成为了CoCoPIE的客户并且正在使用CoCoPIE的产品和技术,未来CoCoPIE将加大在中国的投入,并在成都建立分公司。”

写在最后

时下,人工智能影响着越来越多的行业,物联网、车联网、机器人等,都离不开人工智能技术的壮大与普及,而在人工智能普及过程中,CoCoPIE通过优化模型算法的方式,探索到新的人工智能实现之路。比特网相信,随着人工智能的发展,普惠AI将呈现更多的价值,而CoCoPIE也将得到更多的认可。

X

X

-

微博认证登录

微博认证登录

-

QQ账号登录

QQ账号登录

-

微信账号登录

微信账号登录

企业俱乐部

Copyright (C) 1997-2020 Chinabyte.com, All Rights Reserved